Comment auditer son site avec Screaming Frog (niveau intermédiaire) ?

Votre site est en ligne depuis quelques semaines, plusieurs mois, voire plusieurs années mais vous peinez à apparaître dans les premières pages des moteurs de recherche ? Cela est peut-être dû au non-respect de certains fondamentaux SEO.

Auditer son site est la première étape pour découvrir les points faibles et/ou bloquants afin d’obtenir un meilleur référencement naturel dans les moteurs de recherches. Mais par où commencer, surtout lorsque l’on est débutant en la matière ?

Avant de déléguer cette analyse à un consultant ou une agence spécialisée, vous pouvez tout à fait évaluer certains éléments qui pénalisent votre positionnement, et ce, grâce à de précieux outils. Parmi eux, Screaming Frog, le meilleur « crawler » qui soit. Sa version gratuite, téléchargeable en ligne, vous étonnera tant elle permet déjà d’en dire long sur la santé de votre site web.

https://www.screamingfrog.co.uk/

Un crawler SEO, qu’est-ce que c’est ?

C’est un robot logiciel, aussi appelé « spider » ou « bot », qui explore toutes les pages rattachées à une URL donnée (votre site) dans le but de mettre en évidence des anomalies et erreurs susceptibles de pénaliser son indexation.

Avec les 10 fonctionnalités de Screaming Frog que nous vous présentons aujourd’hui, vous allez rapidement identifier si votre visibilité actuelle est impactée par de mauvaises pratiques.

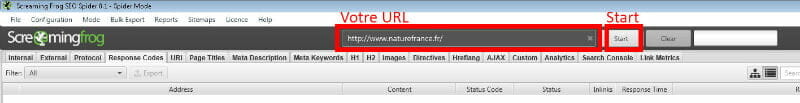

Avant d’aller dans le fond de notre sujet, commencez par renseigner l’URL de votre site dans la barre horizontale : « Enter url to spider » puis cliquez sur « Start » :

Première étape : lancer un crawl en ajoutant l’adresse de votre site web

Vous allez voir apparaître une liste d’URLs : il s’agit de l’ensemble des pages de votre site internet (en réalité, ce sont les 500 premières URLs de celui-ci si vous avez choisi la version gratuite du logiciel, ce qui est généralement suffisant lorsqu’on démarre un audit SEO).

1) Détecter les liens cassés dits « erreur 404 »

Au fil du temps, il est courant voire nécessaire de supprimer certaines pages de votre site internet.

Prenons l’exemple d’un e-commerce dont l’un des produits n’est définitivement plus disponible chez son fournisseur : le e-commerçant fera très certainement le choix de supprimer la page relative au produit. Cependant, cette page a été indexée par les moteurs de recherche et va encore y figurer un moment avant qu’il ne comprenne qu’elle n’existe plus et qu’il faut la désindexer. Si un internaute clique sur ce lien durant cette période, il se verra atterrir sur une page indiquant « error 404 – not found » : de quoi en faire fuir plus d’un ! Vous l’aurez compris, les 404 sont des pages en erreur, inexistantes, mais dont l’URL peut encore être répertoriée par les moteurs.

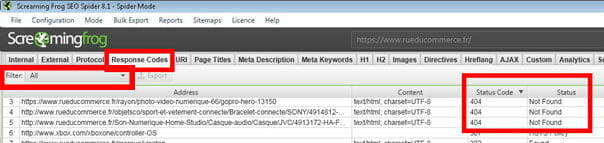

Pour détecter ces éventuelles erreurs sur votre site, rien de plus simple avec Screaming Frog : une fois que le bot a fini son inspection, rendez-vous dans l’onglet « Response Codes », et filtrez les résultats par « Client Error (4xx) ».

Les codes de réponses 4xx témoignent d’erreurs liées au site du client

Cliquez ensuite sur la colonne « Status Codes » pour classer les résultats par ordre décroissant. Si le code 404 apparaît, c’est que certains liens de votre site sont cassés, et il va falloir y remédier sous peine de perdre vos précieux visiteurs, déçus ou inquiets de visiter une page sans contenu. Et pour ce faire, regardons de près les deux fonctionnalités suivantes.

2) Mode Spider et mode Liste de Screaming Frog

Par défaut, la première analyse est réalisée en « mode Spider », ce qui signifie que les résultats vous sont donnés tels qu’ils sont trouvés par le robot.

Néanmoins, vous avez la possibilité d’envoyer vous-même une liste d’URLs de votre choix si votre site en comporte plus de 500 et que vous analysez via la version gratuite : c’est le « mode List », accessible depuis le menu principal. Un simple « copier-coller » ou le téléchargement de fichiers .txt, .xls, .xlsx ou .xml est recevable : pratique !

Deux modes complémentaires pour analyser vos urls

Mais là n’est pas le seul avantage de cette option du crawl : avec ce mode, vous serez ainsi en mesure de cibler pleinement les URLs à analyser, ce qui peut être un réel atout lorsque, par exemple, vous avez migré votre site vers un nouveau nom de domaine, pour vous assurer que chaque URL est bien redirigée.

Rassurez-vous, le point qui suit vous éclairera sur cet aspect technique.

3) Identifier les redirections 301 mal redirigées

Souvent nommée uniquement par son code, « 301 », cette redirection est mise en place lorsqu’on a supprimé une URL existante de son site alors qu’elle est indexée dans les moteurs de recherche : en l’état, nous l’avons vu, cette URL est en erreur 404…

Permanente, la redirection 301 évite qu’un internaute cliquant sur l’URL supprimée ne se retrouve sur cette page introuvable et abandonne sa venue sur votre site. En effet, en cliquant sur le lien désormais absent du site, la 301 va renvoyer le visiteur sur une nouvelle page que l’on a préalablement choisie, sensiblement proche de l’initiale. Ainsi, vous réduisez le risque de laisser partir un internaute à peine arrivé chez vous.

Voyons comment s’assurer que vos 301 fonctionnent parfaitement :

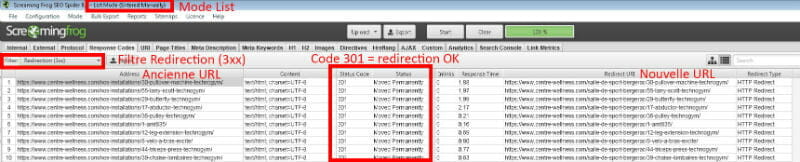

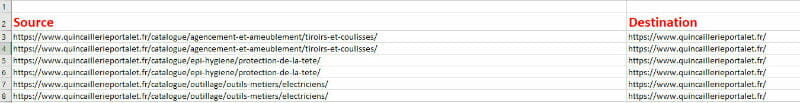

Pour commencer, il convient de disposer de la liste des anciennes URLs, celles qui doivent disparaître. Direction le « List mode » que nous avons abordé précédemment : on uploade la liste en question, puis l’on se rend dans l’onglet « Response Codes » et si le code 301 est présent pour chacune des URLs, alors la redirection permanente est bien en place.

Un response code 3xx fait état d’une url redirigée

Vous noterez qu’en face de chaque ancienne adresse, vous trouverez la nouvelle vers laquelle elle est renvoyée.

Toutefois, si vous apercevez un code 404, vous savez désormais que des corrections seront à apporter.

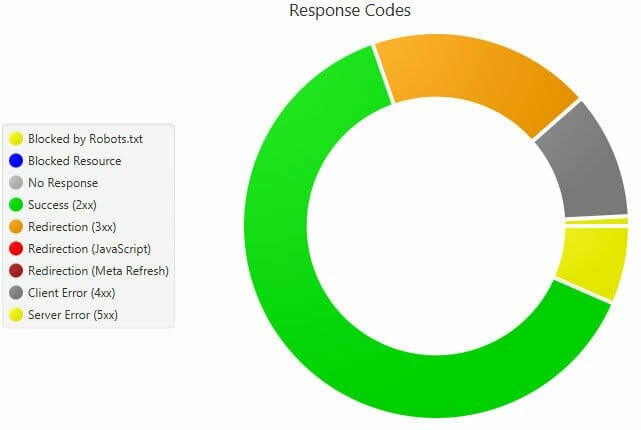

Petit plus non négligeable : Screaming Frog dispose d’une colonne latérale, à droite de l’écran, vous permettant de voir en un coup d’œil comment sont répartis les codes de réponses via des graphes colorés.

Dans le cas de figure ci-après, on peut facilement constater que beaucoup d’URLs sont en 301 mais également en 404.

Les redirections, dont les 301, sont représentées en orange dans le graph « Overview » de Screaming Frog.

4) Longueur des Meta Titles et Descriptions

Autres éléments fondamentaux auxquels vous avez sans doute dû vous confronter lors de la création de votre site internet : les « titles » et « descriptions » rattachés à chacune de vos pages.

Pour rappel, ces balises, autrement connues sous le nom de « meta », permettent d’indiquer le sujet principal de chaque page aux internautes qui les verra apparaître après requête dans les moteurs de recherche. Les Titles sont également considérées par les robots chargés de les indexer et font partie du nerf de la guerre SEO.

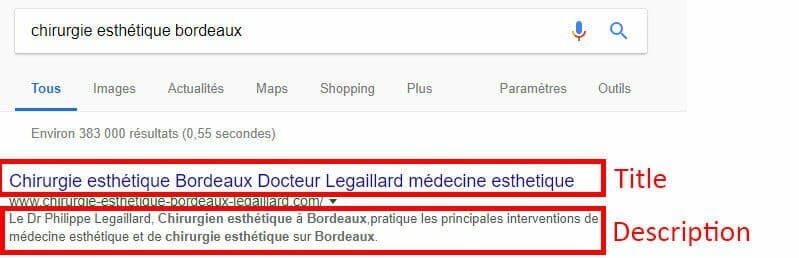

Les voici en image :

Affichage des Meta Title et Description dans un moteur de recherche (Google)

Outre l’importance de bien les rédiger pour qu’elles réfèrent correctement au thème abordé (en y incluant des mots-clés) et qu’elles soient attractives pour inciter au clic, leurs longueurs sont tout aussi essentielles car elles sont limitées par les moteurs de recherche.

Sans rentrer dans les détails du calcul de ces longueurs, il est admis qu’une meta Title peut contenir jusqu’à 72 caractères (espaces compris).

Une balise Description, quant à elle, peut comporter jusqu’à 154 caractères.

Certains CMS ou plugins vous aident parfois à insérer une longueur idéale pour vos meta. Mais plutôt que de reprendre chaque page une à une pour en vérifier ces éléments, lançons Screaming Frog qui nous donnera l’état des longueurs de ces balises pour l’ensemble de notre site.

Cette fois-ci, ce sont les onglets « Page Titles » et « Meta Description » que nous allons observer.

Dans ces onglets, nous allons respectivement cliquer sur « Title 1 Lenght » et « Meta Description 1 Lenght » afin de classer les meta par ordre décroissant.

Classement graduel des meta par nombre de caractères

Avec des Titles dépassant les 72 caractères sur de nombreuses pages, ce site risque d’être pénalisé par les robots…

Grâce à cette fonctionnalité, vous n’aurez pas à écrémer toutes les pages pour vérifier la conformité de ces balises mais irez directement sur celles à corriger.

5) Présence des Meta, unicité / duplication (title, meta description …)

Pour que vos meta Titles et Description soient considérées comme pertinentes par les robots, il ne suffit pas seulement de veiller à leur longueur. Leur contenu est primordial : il doit conférer précisément au contenu de chaque page et par conséquent, ne pas être dupliqué. Toutes vos balises doivent être uniques. Autrement, vous encourez la sanction et risquez de ne jamais arriver à faire votre place dans les moteurs de recherche.

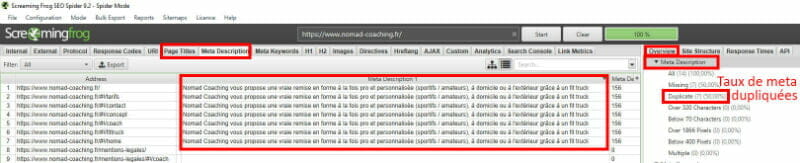

De la même manière que vous avez pu observer la longueur de vos meta via les onglets Titles et Description, rendez-vous dans ceux nommés « Title 1 » et « Meta description 1 ».

Premier indicateur à examiner : « Overview », dans la partie droite du logiciel. Faites défiler le curseur jusqu’à retrouver les sous-rubriques concernées. Si vous observez un taux supérieur à 0 dans la ligne « Duplicate », comprenez que des modifications vont devoir être opérées.

Le contenu des meta ne doit jamais être reproduit d’une page à l’autre

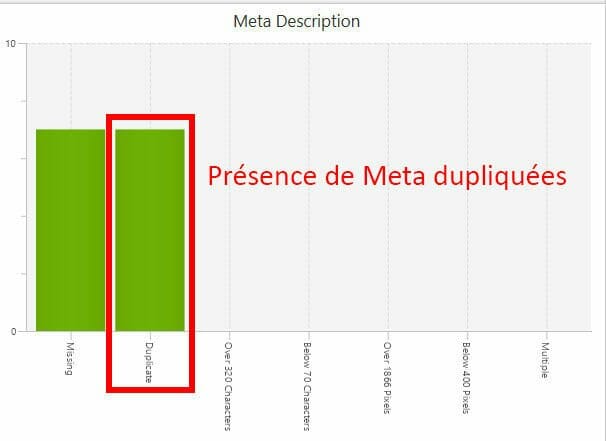

Le graph dans la partie basse, reprenant les mêmes données, vous alertera aussi instantanément si vous découvrez une barre verte rattachée au « Duplicate » :

Des meta descriptions identiques mettent en péril le bien-fondé de vos contenus

Dès lors, cliquez sur les Titles et Descriptions de chaque onglet pour étudier les pages dont les balises sont identiques afin de les corriger ensuite sur votre site.

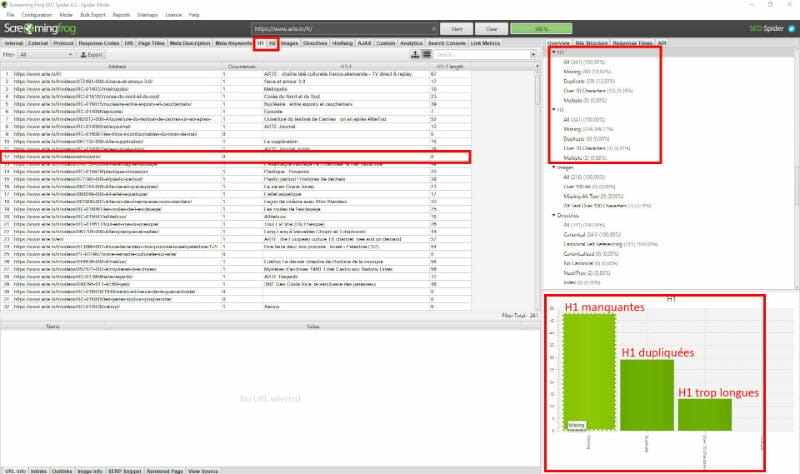

Cette inspection de balises dupliquées est également valable pour ses petites cousines : les « H1 », « H2 » etc… On vous les présente tout de suite !

6) Vérifier la présence des Hn (H1, H2, H3…)

Sous ces courtes dénominations se trouve simplement une autre série de balises qui viennent compléter celles évoquées précédemment. Allant de 1 à 6, les « Hn » aident lecteurs et robots à mieux comprendre votre contenu textuel puisqu’elles font office de titres et sous-titres supplémentaires.

Contrairement à la Title, elles n’apparaissent pas dans les résultats des moteurs de recherche car elles sont uniquement liées à la structure de vos textes et annoncent chacun de vos paragraphes.

Les utiliser fait partie des bonnes pratiques d’optimisation du référencement naturel, sous réserve de respecter une certaine chronologie. En effet, il faut toujours placer en premier une H1 suivie par une ou plusieurs H2, puis les H3, H4 etc…

Rappelons au passage que leur influence pour le SEO est décroissante. Ainsi, vos H1 et H2 ont plus de valeur qu’une H6 aux yeux des algorithmes qui les considèrent.

Ces Hn sont également soumises aux mêmes règles que vos Titles : on doit y retrouver certains de vos mots-clés et elles ne doivent pas être copiées d’une page à l’autre, ni excéder 72 caractères.

Parce que leur absence pourrait vous être fatal, allons désormais voir si elles sont bien présentes sur votre site : direction les onglets « H1 » et « H2 » de Screaming Frog !

L’absence de hiérarchie dans vos paragraphes complique la lecture des internautes et des bots

Vous avez désormais compris le principe : si les graphs liés à nos deux onglets présentent des données, c’est que vos Hn sont absentes et/ou non conformes aux recommandations SEO.

7) Screaming Frog pour l’optimisation des images « ALT »

Halte aux oublis des images « Alt » ! Mais pourquoi ? Et qu’est-ce donc ? On vous explique tout cela.

Diminutif de « alternate text », les ALT sont des balises (oui, encore !) rattachées aux images incluses dans votre site, qu’il convient de renseigner. Tout d’abord parce qu’en cas de chargement impossible ou long de votre image, ce texte viendra s’afficher en remplacement, assurant ainsi la compréhension du sujet malgré le problème rencontré. Mais là n’est pas sa seule utilité. La « ALT » participe également au référencement de l’image si on y intègre judicieusement les mots-clés souhaités. Gardez en tête que ces derniers doivent être en rapport avec le visuel et le texte qui l’entoure.

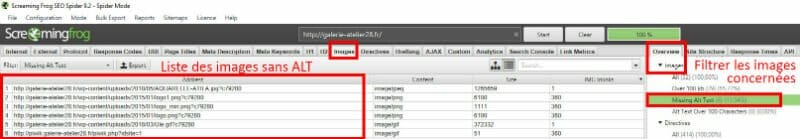

Screaming Frog va encore nous aider à vérifier que ces attributs sont bien renseignés pour toutes vos images. Choisissez l’onglet « Images » puis dans l’Overview, cliquez sur « Missing Alt Text ».

Si un pourcentage est renseigné à côté de cette mention, cliquez dessus : vous disposerez alors de la liste des images dont les ALT ne sont pas renseignées, et ce, dans la partie centrale du soft.

Une image pas ou peu définie risque de pénaliser votre référencement

8) Vue d’ensemble du maillage interne

Un bon maillage interne est un atout supplémentaire pour espérer gagner quelques places de positionnement. Même si vous débutez, vous avez très certainement perçu l’un des intérêts de créer des liens entre certaines pages de votre site : ils fluidifient la navigation des internautes et les incitent au passage à aller plus loin dans leur recherche sur celui-ci plutôt qu’ailleurs. Outre ce point notable, un « internal linking » bien pensé est en mesure de renforcer la visibilité des pages vers lesquelles ces liens pointent. Pourquoi ? Parce que la page qui fait le lien va être considérée comme un soutien de celle qui le recevra. Néanmoins, pour que cela soit jugé convaincant par tous, assurez-vous de faire des liens entre des pages connexes au niveau sémantique.

Lorsque vous disposez d’un vaste site, il est souvent peu aisé de savoir si vous avez fait tel ou tel lien vers telle ou telle page. Et celles qui se trouvent en moyenne à plus de 3 clics de la Home Page ressortent en général plus difficilement dans les résultats de recherche (notamment parce que les robots ne prennent plus la peine d’y perdre du temps). On parle alors de « pages profondes ».

Afin de favoriser celles que vous désirez booster, observer si des liens internes les soutiennent et si ceux-ci ne se trouvent pas trop loin de la page d’accueil devient essentiel.

Retournons donc chez notre amie la « grenouille hurlante » !

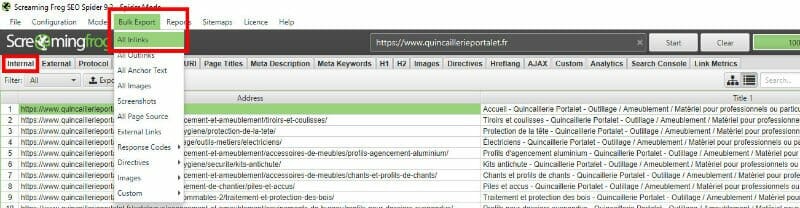

Depuis l’onglet initial « Internal », cliquez sur « Bulk Export » et sélectionnez « All Inlinks ».

L’export de masse fournit rapidement un fichier complet de votre réseau interne de liens

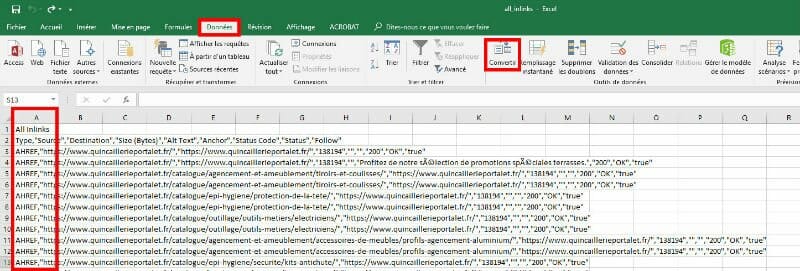

En quelques secondes, vous disposerez d’un fichier Excel où chaque ligne vous indiquera le lien de la page source (contenant le lien) et la page de destination. Attention, en l’état, vous n’y verrez pas grand-chose :

Etape succincte supplémentaire sous Excel pour un meilleur aperçu des liens

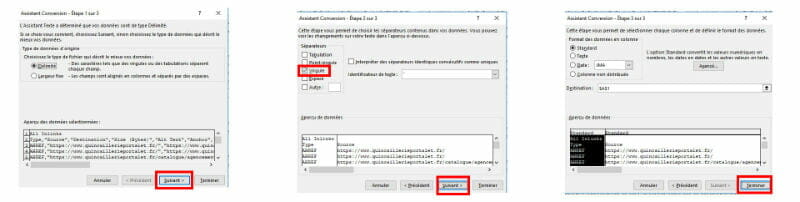

Pour avoir une vision d’ensemble claire de votre maillage interne via cet export, sélectionnez toute la colonne A puis allez dans l’onglet « Données ». Cliquez alors sur « Convertir » et suivez les 3 étapes de l’assistant comme ci-dessous. Il faut simplement sélectionner « Virgule » à l’étape 2.

L’assistant Excel vous guide en 3 clics

Vous disposerez alors de toutes les pages comprenant des liens internes ainsi que des pages vers lesquelles ils pointent.

Fichier final vous présentant les urls incluant des liens internes et leur destination

Vous pouvez dès lors décider en pleine conscience des pages à linker.

9) Déceler les erreurs d’urls canoniques via Screaming Frog

Mettons-nous de nouveau dans la peau d’un e-commerçant pour comprendre le concept d’URL canonique !

Généralement, chaque produit commercialisé dispose d’une ou plusieurs autres versions, parce qu’il est disponible en plusieurs coloris par exemple. Et parfois, même si seule la couleur diffère, le e-commerce le présente sous 2 pages différentes. Mais le contenu textuel associé à chacune de ces variations risque de ne pas vraiment changer d’une page à l’autre. Cela crée alors du « contenu dupliqué » : très mauvais pour votre référencement car on risque la pénalité. C’est là que définir une URL canonique pour chaque page permettra de pallier à ce problème.

En pratique, l’URL canonique est identique à l’adresse de la page. On la précise pour les robots en plaçant une balise (rel= «canonical») dans le code source de chaque page, indiquant l’URL à considérer (dans la partie nommée « head » du code). Ainsi, les bots seront en mesure de n’indexer que la page que vous avez choisie comme principale pour un même produit et ses variantes, et comprendra que votre contenu dupliqué n’est pas à considérer.

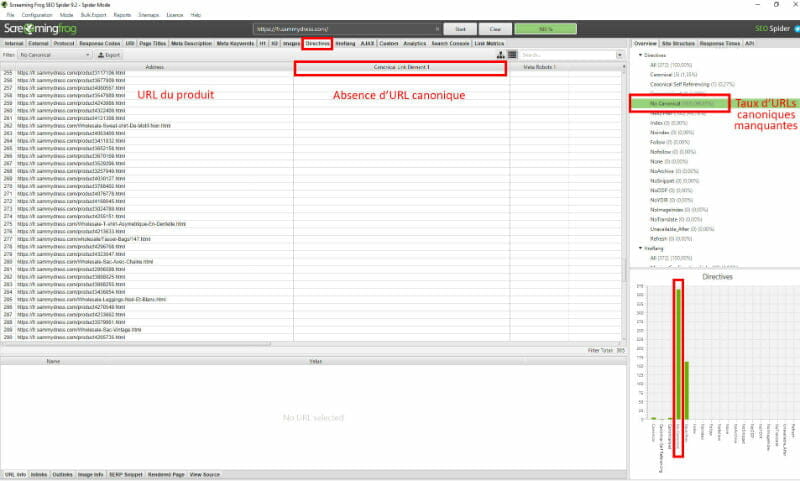

Pour vous assurer que cette règle est bien effective sur votre site, rendons-nous dans l’onglet « Directives » de Screaming Frog !

Si, comme sur l’image ci-dessous, vous découvrez que la colonne « Canonical Link Element 1 » est totalement ou partiellement vide alors que l’URL renseignée sur la ligne associée correspond à celle d’un produit, vous devez faire ajouter cette balise canonique.

Définir une page principale à indexer pour ne pas laisser le robot choisir à votre place et encourir de pénalité

De plus, en exportant les résultats de la section « Directives » sous Excel, vous pourrez aisément vérifier si l’url canonique est différente de l’url principale, et par conséquent, corriger cette erreur pour qu’elles soient toutes deux semblables.

Cette notion de « canonical URLs » est également valable pour les filtres de recherche sur votre site, les sessions utilisateurs, ou si un article est placé à différents endroits du site, mais aussi lorsque vous avez un domaine (https://mondomaine.fr) et un sous-domaine (https://www.mondomaine.fr) tous deux actifs.

10) S’assurer de la présence du code Google Analytics sur l’ensemble des pages

Saviez-vous que ce n’est pas parce que vous avez renseigné votre code Google Analytics sur votre site (dans la page d’accueil par exemple) qu’il est associé à chaque page qui le compose ? Et quoi de plus dommage que ne pouvoir suivre qu’une partie de son trafic ?

Pour ne pas vous retrouvez face à des statistiques de fréquentation tronquées, Screaming Frog vous dira en une minute si ce « tracking code » est bien présent pour l’ensemble de votre site.

Avant tout, précisons que cette fonctionnalité n’est accessible qu’avec la version payante du programme.

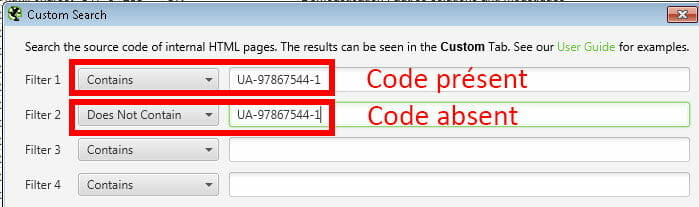

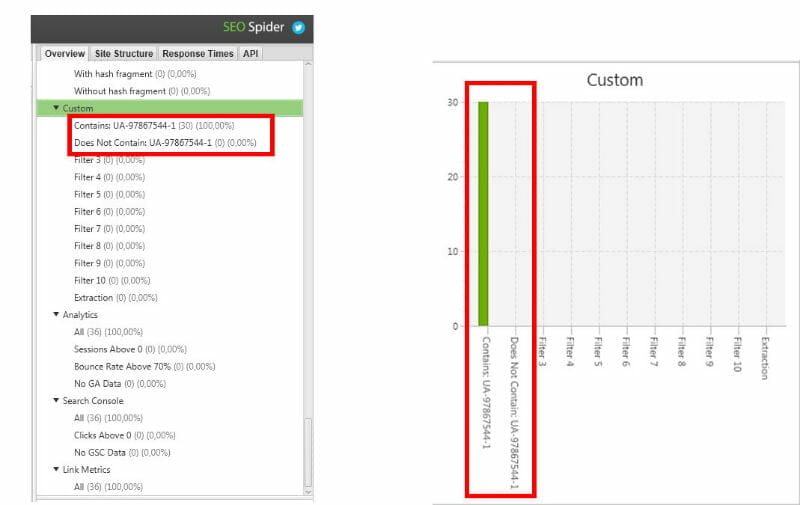

Rappelons également à quoi ressemble ce code : il commence par « UA-» et est suivi d’une série de chiffres. Le voici complet dans notre prochain exemple : UA-97867544-1

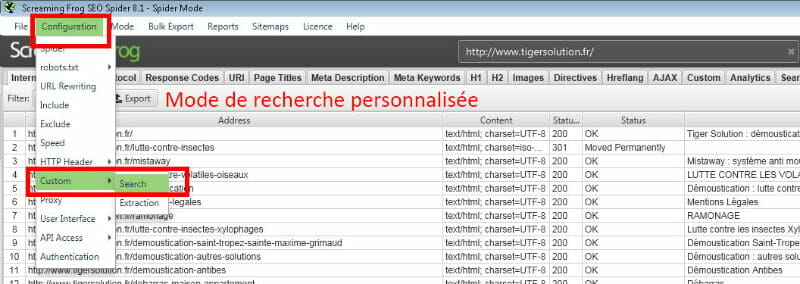

Dans le premier menu de notre logiciel, cliquez sur « Configuration », puis « Custom », puis « Search ».

Cette option permet de personnaliser notre recherche

Une fenêtre s’ouvre alors et vous y renseignerez votre code UA une première fois associé à la ligne « Contains » et dans la ligne suivante en changeant « Contains » par « Does not contain ».

Le filtre sur-mesure est infaillible pour déceler la présence du tracker.

Laissez les autres champs vides et validez. Relancez alors le crawl en cliquant sur Start.

Petit coup d’œil dans l’Overview et faites défiler la colonne jusqu’à visualiser la partie « Custom » :

Vos résultats customisés sont très simples à retrouver dans la partie gauche du logiciel

Ici, le taux de pages ne contenant pas le code Analytics est à zéro : bonne nouvelle, c’est ce qu’il faut !

Comme notre grenouille s’avère d’une aide considérable à bien des égards, nous n’avons pas pu résister : voici une 11ème fonctionnalité, le bonus pour finir !

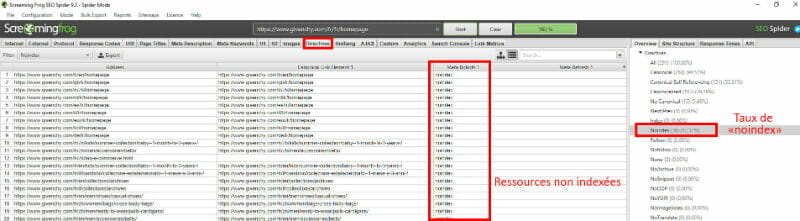

11) Bonus Screaming Frog : Identifier les éventuels « noindex »

Qu’est-ce que le « Noindex » ? Une autre balise qui stipule aux robots de ne pas indexer cette page, tout simplement. Quel intérêt, nous demanderez-vous ? Cela peut être nécessaire si le contenu de ladite page n’est pas assez étoffé, ou pour les PDF que vous ne souhaitez pas voir apparaître dans les moteurs de recherche ou encore les résultats de recherche interne à votre site.

Retournons dans la rubrique « Directives » et, depuis l’Overview, observez si un pourcentage est associé à la la ligne « Noindex ». Si tel est le cas, vous retrouverez l’intégralité des URLS répertoriées ainsi, la mention étant affichée dans la colonne « Meta Robots 1 ».

La présence de noindex n’est pas nécessairement mauvaise : il faut juste s’assurer qu’elle n’est pas liée à une page importante du site

Si cette balise est rattachée à un contenu que vous souhaitez référencer dans les moteurs de recherches, il conviendra de la retirer du code source.

NEW : Mise à jour 5 mars 2019 de Screaming Frog

Bonne nouvelle, Screaming Frog, un des logiciels phares du SEO et du référencement, vient de passer en version 11. Petit tour d’horizon sur les nouveautés proposées par cette nouvelle version, que nous utilisons déjà fréquemment et que nous adorons tout particulièrement.

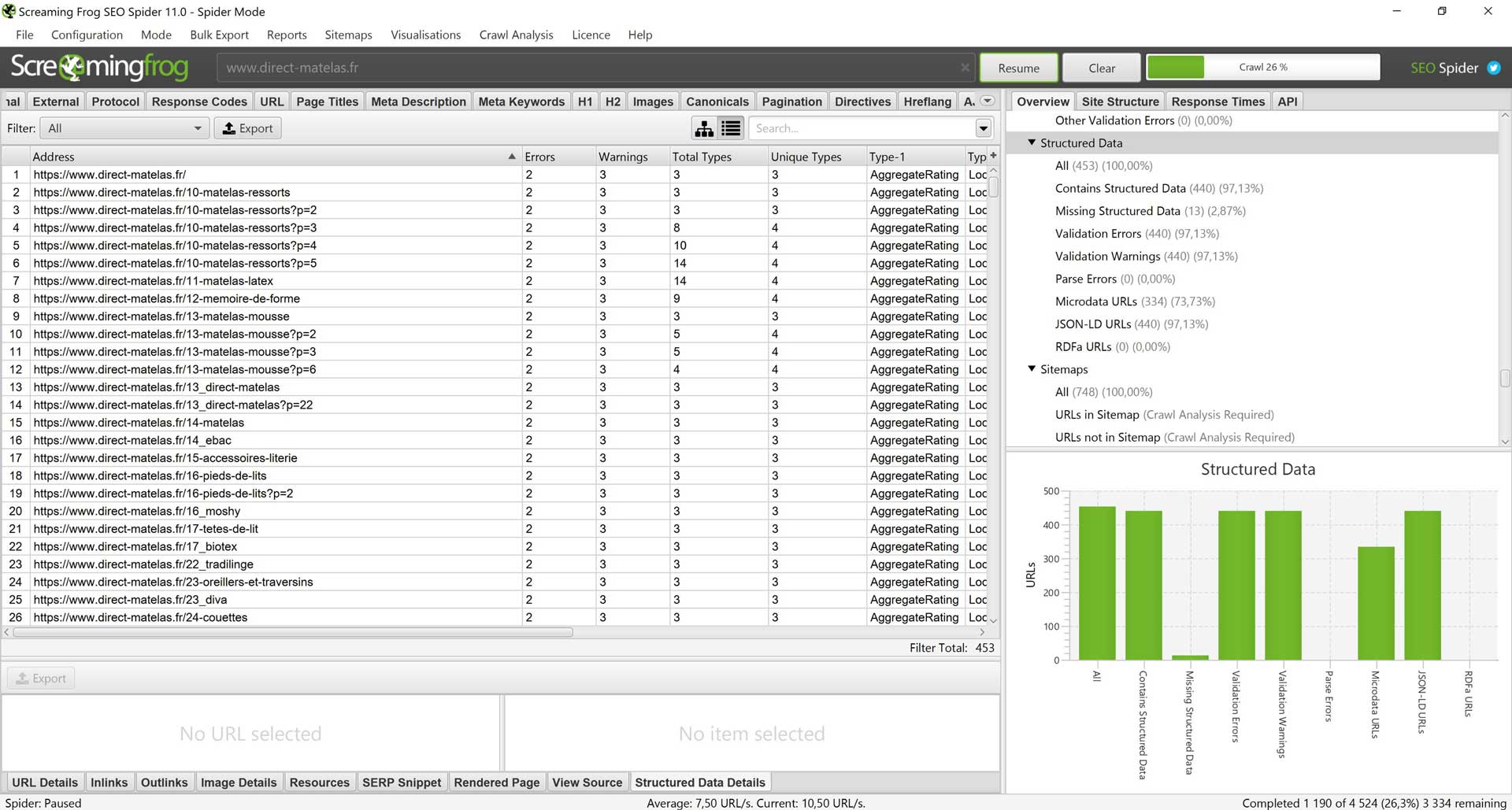

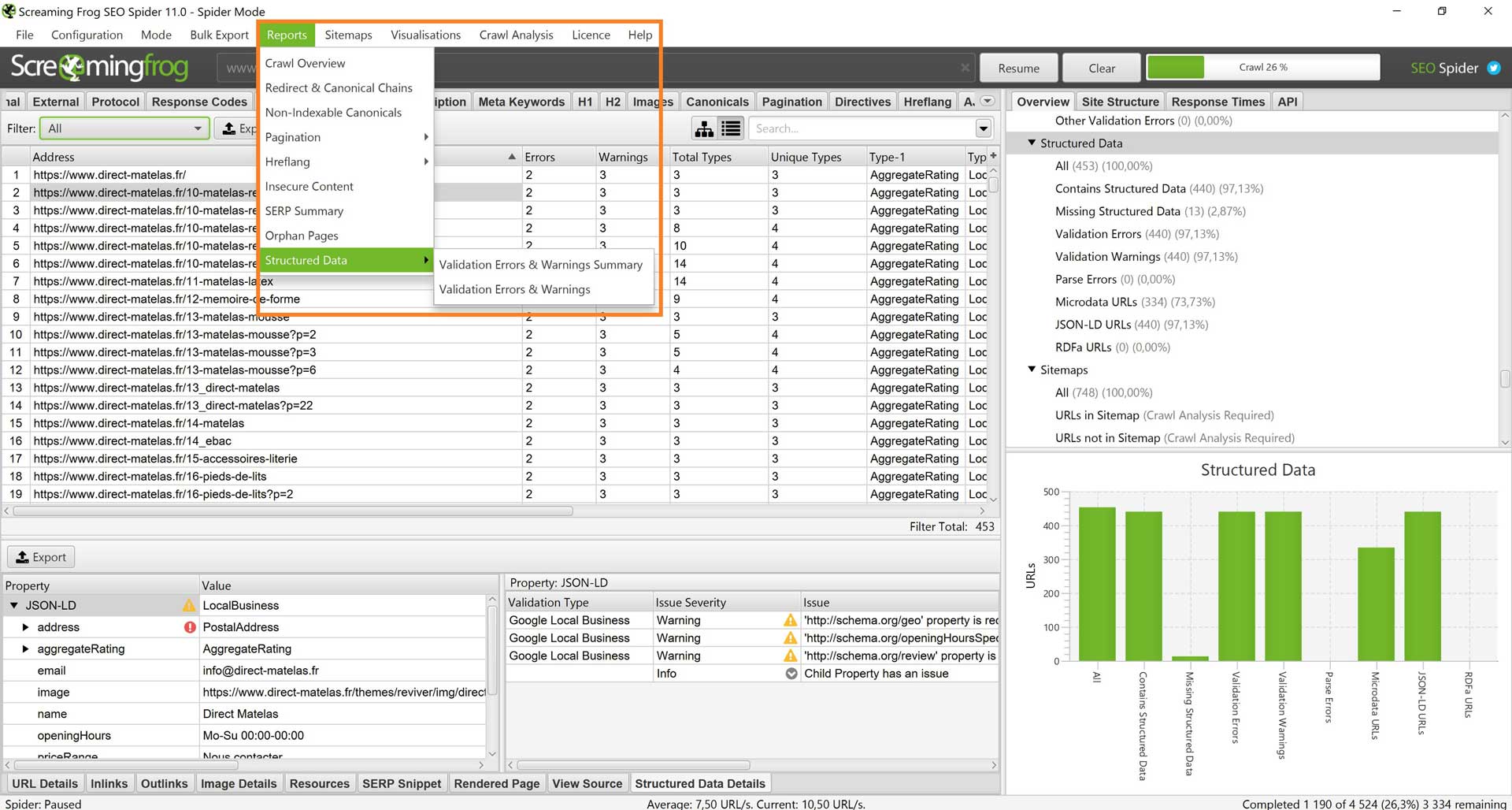

12) Données structurées et validation des données

Les données structurées ne sont pas nouvelles. Elles sont une des nombreuses fonctionnalités à disposition du marketeur pour améliorer la lisibilité et la compréhension d’une page Web à destination des crawlers. Quelquefois, Google assimile bien ces informations et les met en avant dans sa page de résultats notamment, ce qui permet à l’internaute de disposer d’informations complémentaires souvent utiles. Particulièrement évoquées ces derniers temps, les données structurées sont donc incontournables dans une stratégie de visibilité SEO.

Screaming Frog l’a bien compris et a fait un grand pas dans ce sens, en proposant la possibilité d’analyser mais aussi d’extraire ces informations, pour chaque url analysée par l’outil. Actuellement, 3 formats sont pris en considération : JSON-LD, Microdata et RDFa.

Au préalable et afin d’utiliser cette fonctionnalité, une configuration du spider est nécessaire. Pour cela, il suffit d’aller dans « Configuration » puis « Spider », ensuite sur « Advanced » et enfin dans la section « structured data », cocher les cases « extract JSON-LD », « extract Microdata », « extract RDFa », « Schema.org validation », « Google validation » et « Case-sensitive ». Une fois ceci fait, vous pouvez lancer votre crawl et obtenir vos premiers résultats.

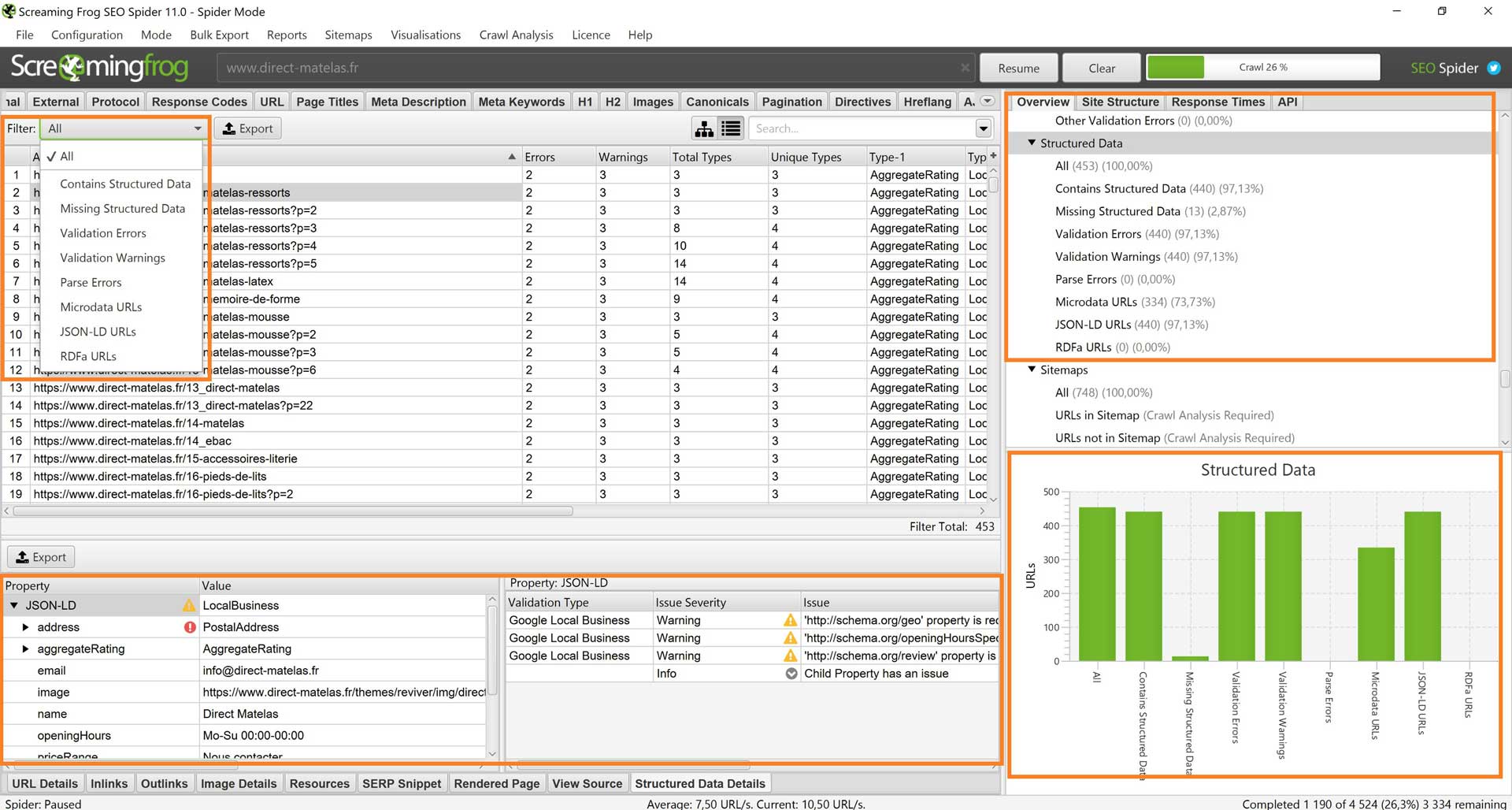

Comme toujours, Screaming Frog propose une vue détaillée et compréhensible, cette fois ci axé sur les données structurées.

Comme vous pouvez le constater, l’affichage est plutôt clair et permet non seulement d’identifier si des données structurées sont implantées ou non, mais aussi si les données structurées sont correctement implantées.

Comme toujours avec Screaming Frog, il est possible de filtrer les résultats, très pratique pour y voir plus clair et se concentrer exclusivement sur un type de problème. Les filtres actuellement disponibles sont :

- Tous : la totalité des urls sont affichées

- Contains Structured Data : uniquement les urls contenant des données structurées sont affichées

- Missing Structured Data : uniquement les urls ne contenant pas des données structurées sont affichées

- Validation Errors : uniquement les urls contenant des erreurs de validité sont affichées

- Validation Warnings : uniquement les urls contenant des avertissements de validité sont affichées

- Parse Errors :

- Microdata URLs : affiche les urls contenant des données structurées au format Microdata

- JSON-LD URLs : affiche les urls contenant des données structurées au format JSON-LD

- RDFa URLs : affiche les urls contenant des données structurées au format RDFa

Les filtres et les vues sont très pratiques pour rapidement identifier les éventuelles erreurs d’un coup d’œil

Le volet inférieur est celui qui fournit les informations les plus précises. On y retrouve pour chaque URL le balisage rencontré, les propriétés qui y sont liées et les valeurs afférentes. Quand un soucis critique est rencontré, une icône rouge est présente. Quand un avertissement est détecté, c’est un panneau warning qui est présenté. La section de droite elle indique le type de validation avec les éventuels problèmes détectés.

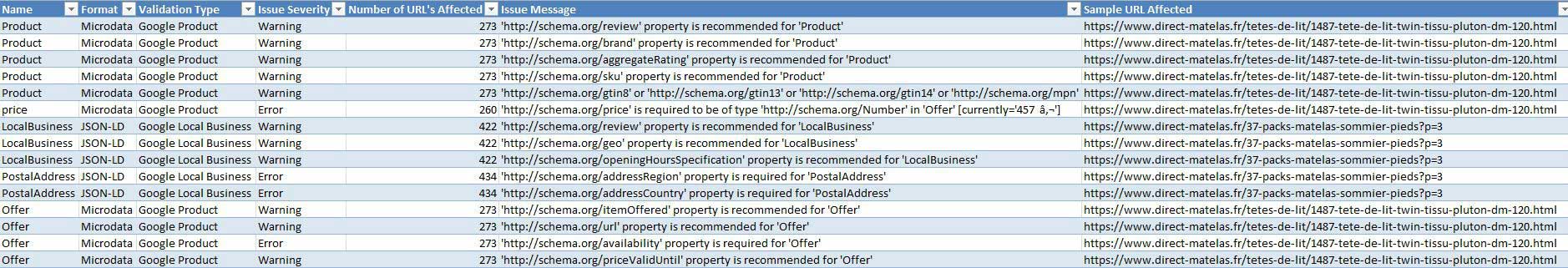

13) Export de masse de données structurées

Dans la continuité de l’analyse des données structurées, le traitement des données est une étape incontournable. Là encore, Screaming Frog nous montre son savoir faire et propose au travers de deux rapports la possibilité d’exporter les donnes.

Les deux rapports exportent les mêmes données, mais la présentation est différente.

- Rapport « Validation errors & warnings summary »

Ce rapport liste les problèmes et alertes par type de données structurées. Etant donné que plusieurs urls peuvent avoir le même problème, le rapport est plus synthétique, et permet d’effectuer des modifications de masse en fonction d’un type de micro donnée.

Un rapport synthétique très pratique pour une compréhension rapide et claire des éventuels soucis de données structurées

- Rapport : « Validation errors & warnings »

Ce rapport liste les problèmes et alertes par url. Etant donné que ce rapport liste les urls avec pour chacune les différents soucis rencontrés, ce rapport est plus long. Il est d’avantage destiné à des modifications précises page par page, qu’importe le type de micro donnée.

Un autre rapport pour une autre approche, cette fois ci plus fine, proposée par Screaming Frog v11

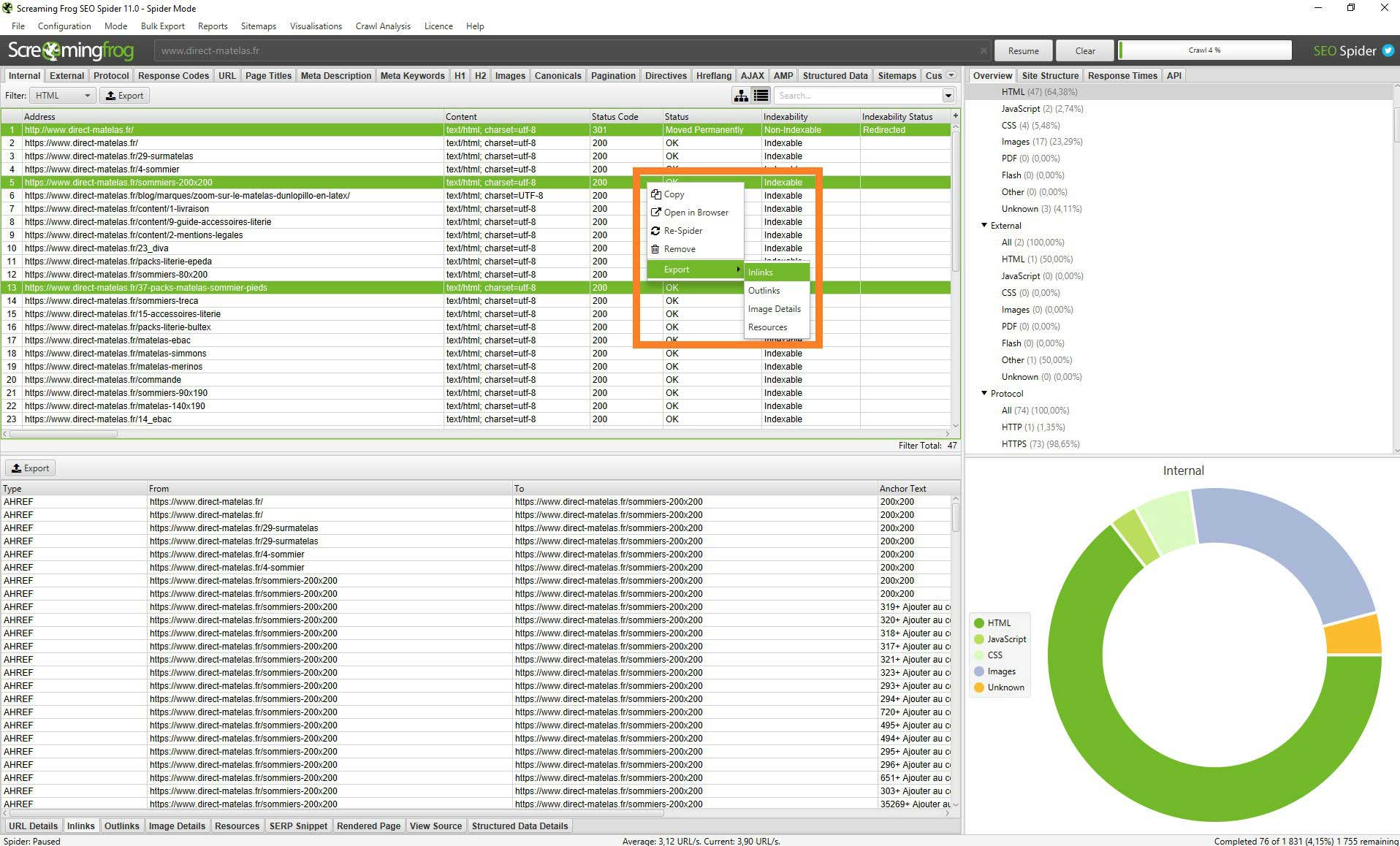

14) Sélection et export de masse des donnes approfondies d’URL sélectionnées manuellement

Autre nouveauté particulièrement utile pour Screaming Frog V11, la possibilité de sélectionner des urls spécifiques, et de pouvoir exporter les détails des pages en question. Il n’est désormais plus nécessaire d’extraire la totalité du fichier pour ensuite faire une série de tri et de filtres, très pratique donc.

La sélection d’url est très utile, pour une analyse fine qui ne nécessite pas l’export total du crawl.

15) Affichage et export du treeview

Dans cette version, Screaming Frog propose également une amélioration significative au niveau de la visualisation des données, avec l’affichage Treeview qu’il est désormais possible d’exporter, avec un respect de l’arborescence du site analysé. Cet affichage est idéal, notamment pour analyser la profondeur de certaines urls et ainsi pousser sa réflexion vis-à-vis du travail d’un crawler et de l’accessibilité des pages, sur le site interrogé.

Comme on peut le voir, l’arborescence est plutôt bien conservée dans le tableur, ici Microsoft Excel

16) Evolution du drag and drop

Pour plus de facilité, Screaming Frog a également fait évoluer son drag and drop. Ainsi, le glissé déposé devient encore plus facile et surtout intelligent, et est désormais en campagne en fonction de l’extension du fichier, de traiter celui-ci de façon adéquate. Si vous souhaitez donc lancer une analyse sur une série d’urls spécifiques, un simple glissé déposé d’un fichier.txt contenant ces urls, suffira à à faire basculer Screaming Frog en mode liste, et enclenchera le crawl.

17) Affichage et export des urls en attente

Autre nouveauté très appréciable, la possibilité désormais d’afficher et surtout d’exporter le urls en de crawl. Si celle fonctionnalité n’est pas forcément très utile lors de petites analyses, elle devient très intéressante quand on attaque plusieurs centaines de milliers d’urls. Une fonctionnalité qui s’appréciera donc en fonction des circonstances et des usages de chacun.

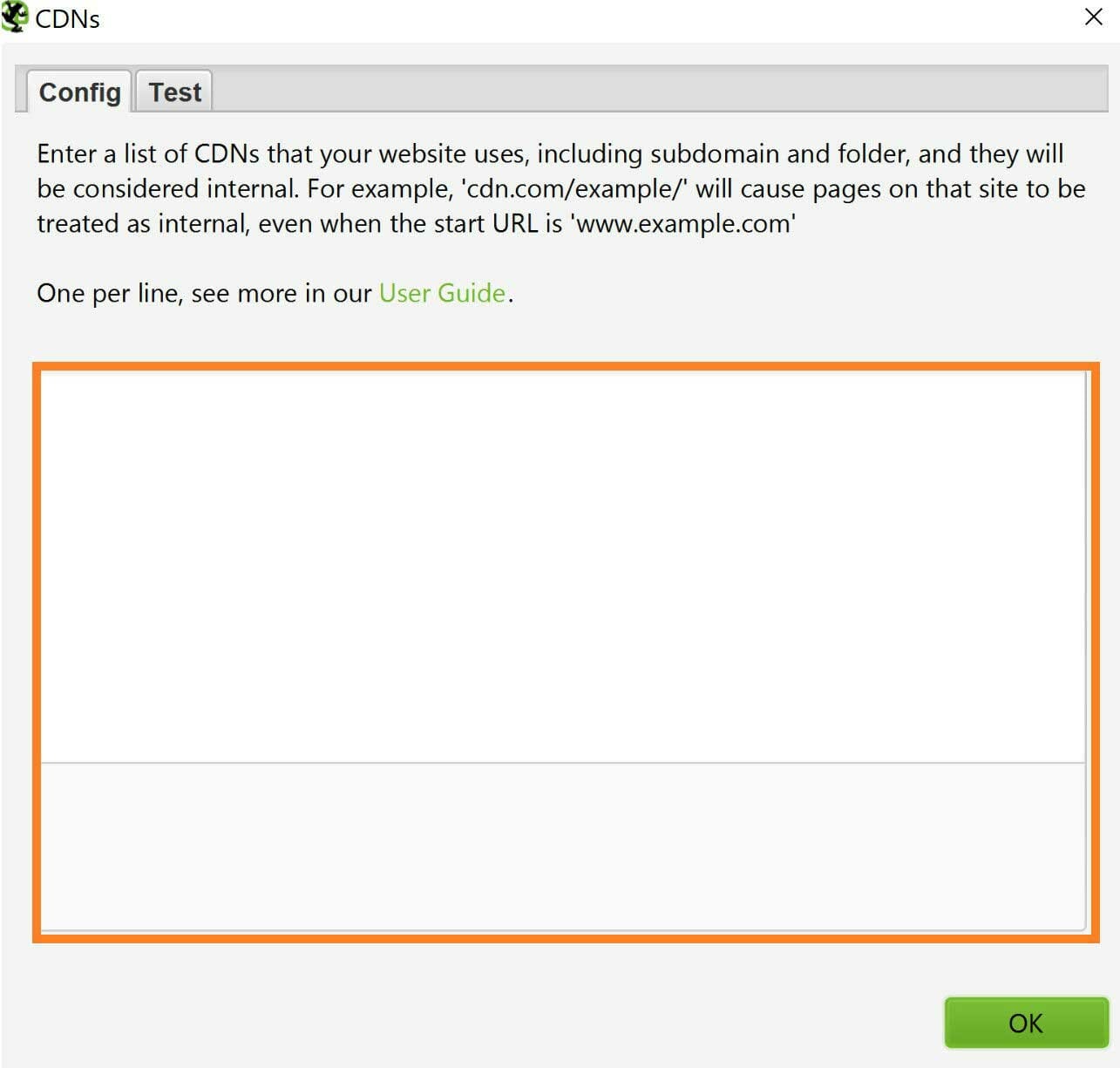

18) Configuration des CDN

Le traitement des CDN est également mis à l’honneur. Les « Content Delivery Network » étant de plus en plus populaires, Screaming Frog offre désormais la possibilité de traiter ceux-ci comme des urls internes.

Les CDN bénéficient eux aussi d’un traitement de faveur dans Screaming Frog v11

Notre conclusion sur Screaming Frog

Vous voilà désormais plus que familier avec le SEO sous Screaming Frog ! En utilisant ces 11 fonctionnalités, l’optimisation SEO de votre site internet devrait finir par être impeccable et porter ses fruits !

Si la version gratuite ne vous suffisait pas, sachez que la licence est accessible pour 149£, soit près de 169€ TTC, et est valable 1an.

Notez toutefois qu’un bon référencement naturel ne dépend pas uniquement des actions réalisées « on-site ». La notoriété de votre site compte tout autant. Aussi, dès lors qu’il n’est pas un ennemi pour lui-même, il faudra sans doute penser à une stratégie de « Link building » pour renforcer vos actions et atteindre cette indispensable visibilité.

Si vous désirez obtenir plus d’informations sur le référencement Screaming Frog, n’hésitez pas à solliciter notre équipe spécialisée.

merci vous êtes au top , parfaitement bien expliqué

Bravo, je crois que de toute les webagency vous etes celles qui communiquent “en clair”. Continuez comme cela !

Concernant screaming frog, y a t’il la possibilité de crawler les urls présentes dans la base de donnée de Google pour un site ?

Je ne trouve aucuns outil capable de faire cela en automatique en lanceant une requete, je suis obligé de me tappé la requete site:votresite.com

Bonjour Denis,

Merci pour votre commentaire.

Pour récupérer toutes les urls de votre site indexées par Google cela va dépendre du nombre d’URLs. Pour quelques dizaines effectivement, la commande site: est ce qu’il y a de plus simple. Vous pouvez ensuite utiliser du javascript pour extraire uniquement les URLs et ensuite les coller dans Screaming Frog.

Pour plusieurs milliers d’URLs, ce sera plus complexe et l’utilisation de proxies sera nécessaire. Ça fera peut-être l’objet d’un prochain article qui sait 🙂

Bonne continuation !

Bonjour,

excellent article, et bonnes captures écran de Screaming frog pour jeter un oeil et comprendre les fonctionnalités disponibles dans le logiciel qui est visiblement l’incontournable pour réaliser de sérieux audit SEO. Merci beaucoup.